随着人工智能技术从实验室走向规模化应用,企业级AI项目的成功实施已不再仅仅依赖于模型本身的性能,更依赖于一套严谨、规范且可复制的流程与方法论。传统的敏捷或瀑布模型在应对AI项目的高度不确定性与迭代性时往往力有不逮。本文将深入探讨如何基于OODER(目标定义、方案设计、数据开发、模型训练、效果评估、持续迭代)框架,构建一个从战略到落地的规范执行计划,并阐述大模型(LLM)在此流程中的关键协作角色,同时提供数据处理与存储支持服务的核心要点。

一、 OODER框架:企业级AI实施的规范蓝图

OODER框架将AI项目周期划分为六个紧密衔接、循环迭代的阶段,为项目提供结构化指引。

- 目标定义: 这是所有工作的起点。必须将模糊的业务需求转化为清晰、可衡量、可实现的AI目标。关键活动包括:与业务部门深度对齐,识别核心痛点;定义具体的成功指标(如准确率提升X%、人力成本降低Y%);评估技术可行性与资源约束。大模型在此阶段可作为“智能顾问”,通过分析历史报告、市场数据,辅助生成更全面的机会洞察与风险预判。

- 方案设计: 基于明确的目标,设计技术实现路径。这包括选择问题范式(分类、回归、生成等)、确定模型技术选型(是否使用预训练大模型、微调还是从头训练)、规划系统架构(离在线推理、API服务等)。大模型可协助进行技术方案对比、生成部分架构文档或伪代码,加速设计进程。

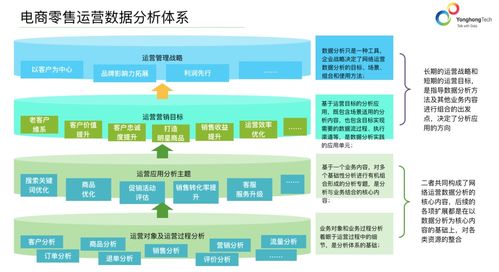

- 数据开发: “数据是AI的燃料”。此阶段聚焦于获取、清洗、标注、增强和管理训练与评估所需的数据集。需建立严格的数据质量标准与安全合规流程。支持服务需提供高效的数据湖/仓、强大的ETL工具以及可能的数据标注平台。大模型可用于自动数据清洗、生成合成数据以解决小样本问题,或辅助进行更智能的数据标注。

- 模型训练: 在准备好的数据基础上进行模型开发。对于大模型应用,此阶段可能涉及提示工程、检索增强生成(RAG)管道构建、模型微调(Fine-tuning)或轻量化训练。关键在于建立标准化的实验跟踪与管理体系,记录每一次训练的超参数、数据版本和性能结果,确保可复现性。

- 效果评估: 模型训练完成后,必须在独立的测试集和贴近真实的业务场景中进行全面评估。评估不仅包括准确率、F1值等技术指标,更要关注业务指标(如用户满意度、转化率)以及对潜在偏差、公平性的审计。大模型可以辅助生成多样化的测试用例,或作为“批判性评审”分析模型输出的合理性与安全性。

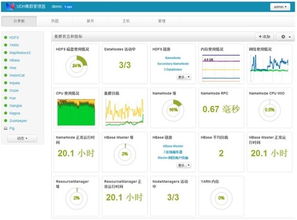

- 持续迭代: AI模型上线并非终点,而是持续优化的开始。需要建立监控系统,跟踪模型在生产环境中的性能衰减、数据漂移和用户反馈。基于监控数据,触发模型重训练、参数调整或流程优化,形成“定义-设计-开发-训练-评估”的闭环。大模型可自动化分析监控日志,识别异常模式,并提出迭代优化建议。

二、 大模型在OODER全流程中的协作模式

大模型不仅是最终的应用输出者,更是全流程的“增强智能”协作者。其协作模式可分为三类:

- 辅助决策与创造: 在目标定义、方案设计阶段,提供信息整合、方案草拟和创意激发。

- 自动化执行: 在数据开发、代码生成、文档编写、测试用例生成等环节,替代部分重复性劳动,提升效率。

- 分析与评审: 在效果评估与迭代阶段,对模型输出、系统日志进行深度分析,发现人难以察觉的模式与问题。

企业需根据自身情况,明确在哪些环节、以何种程度引入大模型协作,并制定相应的Prompt规范、输出验证与安全管理流程。

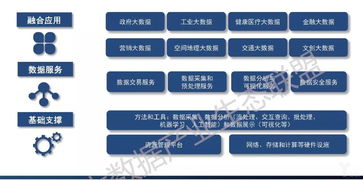

三、 数据处理与存储支持服务:坚实底座

可靠的数据基础设施是OODER流程顺畅运行的基石。关键服务包括:

- 统一数据平台: 构建企业级数据湖/数据仓库,实现多源异构数据的集中接入、存储与管理,为AI训练提供“单一数据源”。

- 数据治理与安全: 实施数据分级分类、访问权限控制、隐私计算(如联邦学习)等技术,确保数据在合规前提下安全使用,满足GDPR等法规要求。

- 特征平台: 提供特征存储、计算、管理与服务的一体化能力,确保训练与推理阶段特征的一致性,加速模型迭代。

- MLOps管道: 将数据版本化、模型版本化、自动化训练与部署流水线整合,实现从代码提交到模型上线的自动化,是支持“持续迭代”阶段的核心技术设施。

- 向量数据库支持: 对于大模型RAG应用,需集成高性能的向量数据库,用于存储和快速检索非结构化数据(文档、知识)的嵌入向量。

###

企业级AI的成功是一项系统工程。采用OODER框架能够为项目提供清晰、规范的执行路线图,有效管理项目风险与不确定性。而将大模型深度融入这一流程,作为“思考伙伴”与“效率引擎”,能够显著提升各环节的智能水平与执行速度。这一切都离不开一个强大、灵活、安全的数据处理与存储服务体系的支撑。只有将方法论、智能体与基础设施三者有机结合,企业才能在AI驱动的未来竞争中构建起坚实且可持续的核心优势。